Introducción

La evaluación del alumnado es un tema sensible e influye en los indicadores de rendimiento, por lo que es importante contar con procedimientos adecuados a la hora de pensar el proceso de evaluación (Caro y Ahumada, 2018a).

Con el propósito de aportar a la mejora de la evaluación del estudiantado en un contexto de virtualidad, se presenta en este trabajo un proceso de validación de cuestionarios, en el que se utilizaron las funcionalidades disponibles en la herramienta cuestionario de Moodle [1], que le permitan al equipo docente evaluar con instrumentos de calidad.

La necesidad de generar dispositivos de evaluación confiables constituye una ventaja estratégica para la institución universitaria, ya que incentiva una mayor incorporación de las tecnologías de la información y la comunicación (Caro y Ahumada, 2018a).

Ante una adecuada elección y aplicación de las tecnologías en entornos virtuales, donde la masividad propone pensar la evaluación como un proceso que mejora la enseñanza y el aprendizaje, las aulas virtuales ofrecen una serie de recursos que facilitan estos procesos. Entre estos recursos se encuentran las evaluaciones que pueden gestionarse en tiempo real en la plataforma Moodle. Es una buena estrategia utilizar una plataforma en donde, además de organizar los contenidos y utilizar recursos en diferentes formatos, se ofrezcan oportunidades de autoevaluación.

El uso de cuestionarios a través de Moodle permite elaborar instrumentos que requieren ser evaluados de manera continua, con lo que se logra su fiabilidad y validez. Esto es posible a través de un conjunto de indicadores que permiten, luego de la implementación del cuestionario, ser analizados para optimizarlos y lograr la mejora de estos instrumentos en los procesos de evaluación.

En 2016 se incorporaron cambios importantes en las técnicas de evaluación en un curso de Estadística I de la FCE de la UNC, ''sostenidos en el enfoque de una apropiada evaluación formativa, acorde al contexto institucional en el que se desarrolla la asignatura y con el objetivo de generar una mejora del aprendizaje que pudiera ser significativamente tangible” (Caro y Ahumada, 2018a, p. 2). Medina-Rebollo et al. (2019), respecto a los instrumentos de evaluación, plantean que:

Se hace necesario el análisis y la reflexión, que nos permitan conocer los puntos fuertes para reforzarlos y mantenerlos; y determinar los puntos débiles que nos permitan plantear propuestas y alternativas de mejora, haciendo un esfuerzo por mejorar la calidad de nuestra enseñanza. (p.3)

Este trabajo contribuye en la validación de cuestionarios con la finalidad de lograr evaluar con calidad al estudiantado, ya que se ha comprobado que el equipo de educadores plantea sus evaluaciones sin realizar un análisis exhaustivo de sus resultados. Motivado en esto, se analiza un conjunto de indicadores reportados por la herramienta que dan cuenta de qué preguntas deben ser revisadas, corregidas o modificadas, a fin de obtener instrumentos idóneos para evaluar. De esta manera se construyen bancos de preguntas que permiten una evaluación permanente, con medios digitales y de calidad.

Ante el problema planteado de la falta de medición de la fiabilidad y validez del instrumento de evaluación, se establecen los siguientes objetivos:

Objetivo general:

Analizar la implementación de evaluaciones formativas mediante herramientas digitales en grupos masivos de la materia Estadística I.

Objetivos específicos:

Identificar las posibilidades de la herramienta cuestionarios de la plataforma Moodle en el diseño de instrumentos de evaluación.

Validar los cuestionarios a los fines de generar confiabilidad en los resultados obtenidos por el estudiantado.

Examinar la valoración del estudiantado respecto a la evaluación a través de estos instrumentos.

Este artículo presenta, a continuación, una descripción del marco teórico, luego la metodología llevada a cabo en la que se describe el tipo de investigación, la muestra, lo concerniente a la elaboración del cuestionario y sus indicadores de validación. A continuación, se presentan los resultados obtenidos a la luz de los objetivos propuestos y, por último, las conclusiones.

Marco teórico

La propuesta de enseñanza y aprendizaje debe abordar el contenido curricular que se propone transmitir en entornos cada vez más complejos, donde la evaluación tiene un interés especial y debe ser abordada con un análisis crítico completo e integral a través de instrumentos que permitan generar información sobre la calidad de la propuesta. Como aporta De Camilloni et al. (1998), ''la evaluación es parte del proceso didáctico e implica para los estudiantes una toma de conciencia de los aprendizajes adquiridos y, para los docentes, una interpretación de las implicancias de la enseñanza en esos aprendizajes” (p.16).

En la actualidad, y sumado a los requerimientos de los organismos de evaluación, ofrecer una enseñanza de calidad se ha tornado en preocupación, donde una de las posibilidades es el uso de las plataformas como recurso educativo que abarca los procesos de enseñanza y aprendizaje (Tirado-Morueta y Hernando-Gómez, 2011).

Caro y Ahumada (2018a, 2018b), citando a Blanco y Ginovart (2012), exponen que varios estudios han puesto de relieve el papel cada vez más importante de las tecnologías de la información y la comunicación en el campo de la evaluación (Delgado-García y Oliver-Cuello, 2006; Graff, 2003, Steegmann et al., 2008), hasta el punto de poner a la evaluación virtual como un elemento importante en el ámbito educativo (Brink y Lautenbach, 2011; Crews y Curtis, 2011; Daly et al., 2010; Ferrão, 2010).

Villamizar-Rodríguez (2005) conceptualiza a la evaluación como un conjunto de procesos sistemáticos que, comparados con situaciones de referencia o con criterios establecidos, permite la toma de decisiones a fin de favorecer la mejora del proceso de evaluación en sí mismo.

Ryan et al. (2013) plantean, también, la evaluación de los aprendizajes como un proceso, en el que el estudiantado manifiesta sus competencias y progresos.

La evaluación de los aprendizajes arroja juicios de valor sobre las actuaciones y producciones del estudiantado que procuran la mejora de la educación; por lo que puede tener diversas finalidades, evaluación diagnóstica, formativa y sumativa, entre otras.

Por otra parte, referente a los entornos más complejos en lo que la evaluación tiene lugar, Raichman et al. (2011) expresan que ''la generación de nuevos entornos de aprendizaje está íntimamente asociado a las vinculaciones interactivas y asociativas que se tenga capacidad de lograr con la utilización de los recursos tecnológicos disponibles para el desarrollo de prácticas educativas innovadoras” (p.24).

En ese marco, al identificar la disponibilidad real de recursos tecnológicos y siempre en busca de garantizar la accesibilidad del estudiantado, es que las virtudes de la plataforma educativa Moodle se tornaron una herramienta atractiva para indagar en el diseño de intervenciones durante el proceso de enseñanza, especialmente vinculadas a diferentes instancias de evaluación apropiadas al estudiantado.

Caro y Ahumada, (2018a) indican que:

La evaluación como tema crítico puede ser abordado de distintas maneras, pudiendo clasificar a los cuestionarios en dos grupos: formativos y evaluativos.

∙ Cuestionarios Formativos: El objetivo es aprender. El estudiantado tiene la oportunidad de intentar varias veces resolver el mismo examen o la misma pregunta, pues el objetivo es, que si identifica que ignora algo, lo aprende al resolver el examen.

∙ Cuestionarios Evaluativos o Sumativos: El objetivo es valorar si se otorgan o no los créditos del tema/curso.

Los cuestionarios en Moodle no sólo han demostrado ser útiles para llevar a cabo evaluaciones, sino que pueden ser modificados y adaptados según las necesidades de los procesos de enseñanza y de aprendizaje. Tales ajustes pueden ser propuestos con fundamentos basados en el análisis de los índices psicométricos que se obtienen a partir de la misma plataforma Moodle (p.2).

Segura-Castillo (2018) manifiesta que la evaluación formativa considera tanto el desempeño individual como grupal del estudiantado. A través de diferentes instrumentos de evaluación, entre ellos los que pueden elaborarse en Moodle, se puede recopilar información al observar dicho desempeño, lo que permite retroalimentar el proceso de evaluación. A través de autoevaluaciones, el estudiantado aprende, se autocorrige y se prepara para otras instancias en su proceso de aprendizaje.

Los cuestionarios del entorno Moodle no solo han demostrado ser útiles para llevar a cabo dichas actividades evaluativas, sino que además pueden modificarse y adaptarse según las necesidades del alumnado (Blanco y Ginovart (2012).

Calvo-Iglesias (2017) exhibe experiencias interesantes en la que se aprovechan las amplias posibilidades didácticas que tiene la plataforma Moodle, con el objetivo de fomentar la participación del estudiantado en el proceso de evaluación y, por lo tanto, en su aprendizaje. En sus prácticas como docente combina varias estrategias en torno a la evaluación, las cuales aplica a los cuestionarios de Moodle, como evaluaciones iniciales, autoevaluaciones y otra técnica de evaluación por pares. El autor arriba a conclusiones sobre la participación de sus estudiantes en estas actividades y manifiesta la importancia de mejorar el diseño de los instrumentos. Es por ello que agudizar la mirada en la calidad de los cuestionarios, debe ser parte de la tarea de evaluar, sin importar el modo o tipo de evaluación que se practique.

Distintas experiencias han sido desarrolladas en torno a la plataforma Moodle con resultados muy satisfactorios. Cejudo (2007) presenta a la plataforma Moodle como una herramienta con mucha potencialidad en un entorno de software libre; Galán y Mateos (2012) hacen hincapié en que recoger toda la información generada en Moodle, a través de sus indicadores, es de utilidad para el proceso de evaluación en educación superior.

El recurso Cuestionario de Moodle está especialmente dotado de herramientas que, a través de un análisis psicométrico, permiten explorar otros modos de evaluar (Blanco y Ginovart, 2012) que representen una alternativa novedosa en comparación con las tradicionales metodologías. A través de este análisis de ítems (preguntas) del cuestionario se generan informes que, luego de una lectura detallada, contribuyen a la mejora del cuestionario para una instancia posterior y procura obtener instrumentos de evaluación de calidad. Díaz y Gonzales (2021) presentan una guía detallada para crear, editar, calificar y descargar cuestionarios en Moodle.

Metodología

El presente trabajo se basa en un estudio de tipo cuantitativo, aplicado, en el que se trabajó con datos primarios, es no experimental y de corte transversal con el objetivo de explorar las habilidades adquiridas por el estudiantado y determinar la fiabilidad del cuestionario. Inicialmente se aplicó el instrumento de evaluación a una muestra de estudiantes, quienes realizaron de manera optativa una autoevaluación; luego del análisis y mejora del instrumento, este se aplicó a otro grupo de estudiantes. Se aplicaron métodos de estadística descriptiva, ya que se analizaron los indicadores que reporta Moodle y que permitieron validar el cuestionario y volver a aplicarlo en otros grupos con la intención de mejorar la evaluación. Se realizaron pruebas de inferencia, test t, para comparar los resultados en función de la participación de los diferentes grupos de estudiantes.

Por último, se utilizaron herramientas cualitativas de análisis textual a fin de recoger las valoraciones del estudiantado sobre diversos aspectos de la evaluación. El instrumento de recolección de datos es el cuestionario de evaluación con preguntas y ejercicios cuyo resultado es dicotómico: correcto / incorrecto.

Muestra:

Se trabajó con una muestra de entrenamiento formada por 63 estudiantes que se evaluaron a través de un cuestionario en 2016. Luego de la validación del instrumento, a través del análisis de indicadores, se modificó el cuestionario y se le aplicó en otra muestra de 29 estudiantes en 2017. Se trata de muestras no probabilísticas, formadas por estudiantes que optaron por realizar cada una de las evaluaciones.

Elaboración del instrumento:

Para la elaboración del instrumento de evaluación se cumplieron etapas sucesivas, en vistas al objetivo último que es evaluar al estudiantado en Estadística.

En primer lugar, la etapa de diseño plasmó una serie de decisiones que iban desde evaluar, desde la virtualidad, qué recursos eran requeridos, cómo evaluar, qué tipo de preguntas, entre otras cuestiones. Se diseñaron categorías en función de las unidades temáticas del curso y subcategorías dentro de ellas.

La etapa de preparación implicó construir un Banco de Preguntas, organizadas por contenidos de la asignatura, lo que permitió el agrupamiento de consignas en diferentes categorías. Caro y Ahumada (2018a) consideran que:

La importancia que tiene darle una estructura al banco de preguntas es permitir la reutilización de las mismas, ya que el banco de preguntas es escalable, año a año se pueden sumar preguntas a las categorías de preguntas creadas, o crear nuevas categorías y también modificar las preguntas para mejorarlas, ampliarlas, etc. (p.3).

La etapa de aplicación requiere la organización de aspectos operativos, tales como el espacio para la evaluación, el tiempo disponible y que se trata de una preparación para evaluaciones futuras. Dado el carácter evaluativo, el alumnado realizó la actividad evaluativa de manera individual en aulas de la FCE con las medidas de seguridad correspondientes. En estas condiciones, el estudiantado demostró sus habilidades y competencias que permitieron validar el instrumento de evaluación (Caro y Ahumada, 2018a).

Las etapas de valoración y devolución aplicables en los cuestionarios de Moodle, incluyen la ponderación o peso de cada pregunta y también incluir la respuesta correcta como retroalimentación a cada pregunta (correcto o incorrecto) o a todo el instrumento. El hecho de realizar una devolución de manera clara le permite al estudiantado comprender cuáles fueron los errores cometidos. (Caro y Ahumada, 2018a).

Estos cuestionarios fueron administrados durante el dictado del curso (proceso), a medida que se desarrollaron los temas del programa. La propuesta fue optativa y permitió comparar a quienes hicieron las evaluaciones versus quienes no las realizaron.

En 2016 se realizaron cuatro evaluaciones. Se formaron dos grupos, en uno de ellos se incluyó a quienes realizaron tres o más cuestionarios (alta participación), y en el otro grupo quienes realizaron dos o menos cuestionarios (baja participación). También se comparó a quienes no realizaron autoevaluaciones versus quienes sí realizaron. Ambas comparaciones se probaron a través de test t de hipótesis (Caro y Ahumada, 2018b).

Indicadores de validación del instrumento:

Para poder validar el cuestionario se utilizaron indicadores generados de manera automática y reportados por Moodle, calculados con base a las respuestas obtenidas del estudiantado que permiten evaluar el instrumento en forma global y a cada una de las preguntas o ítems.

Los indicadores globales se conceptualizan en la Tabla 1 y pueden ser clasificados en:

a) descriptivos (promedio, calificación mediana, asimetría y curtosis)

b) de fiabilidad (consistencia interna, ratio de error y error estándar)según lo presentado por Caro y Ahumada (2018a).

Tabla 1 Estadísticas globales del cuestionario.

| Indicador | Significado | Valor teórico |

| Promedio de los intentos | Promedio de las calificaciones obtenidas por el estudiantado que finalizó el cuestionario | 50 % a 75 % |

| Calificación mediana | Mediana de las calificaciones | -.- |

| Desviación estándar | Promedio de diferencias en las calificaciones alrededor del promedio | 12% a 18% |

| Asimetría de la distribución de puntuaciones | Discrimina entre las calificaciones. Valores positivos indican la presencia de unos pocos valores de calificaciones altas y valores negativos indican presencia de pocos valores bajos | -1 a 1 |

| Curtosis de la distribución de puntuaciones | También es una medida que discrimina entre el alumnado. Una alta curtosis puede indicar que el cuestionario no está discriminando muy bien, comparando los extremos con el estudiantado promedio. | 0 a 1 |

| Coeficiente de consistencia interna (para todos los intentos) | Estimación de la fiabilidad de una prueba psicométrica. Un bajo valor indica, o bien que algunas de las preguntas no son muy buenas para discriminar el nivel de conocimiento del estudiantado o bien puede revelar que algunas de las preguntas están funcionando con una calidad diferente al resto, lo que provoca que el examen en su conjunto no sea homogéneo | Más de 70 % |

| Ratio de error (para todos los intentos) | La tasa de error estima el porcentaje de la desviación estándar que se debe a efectos aleatorios en lugar de diferencias auténticas en la habilidad entre estudiantes | Menos de 50 % |

| Error estándar (para todos los intentos) | Es una medida de la incertidumbre en la calificación de cualquier estudiante dado (es la desviación estándar multiplicada por la tasa de error y dividida por 100). | Menos del 8 % |

Fuente: elaboración propia con base en Caro y Ahumada (2018a)

A continuación, se puede analizar de manera detallada cada una de las preguntas del cuestionario, ya que Moodle calcula y reporta una serie de indicadores, que se presentan en la Tabla 2. A su vez, individualmente se puede profundizar el análisis pregunta por pregunta, así los indicadores que se obtienen permiten analizar el aporte de cada pregunta a la prueba global.

Tabla 2 Estadísticas de las preguntas o ítems.

| Indicador | Significado | Valor teórico |

| Índice de facilidad / Nivel de dificultad | Es la puntuación promedio del estudiantado en la pregunta (porcentaje de aprobación de las preguntas sobre el total de intentos para responderla) | Hasta 5: extremadamente difícil. 6 - 10: muy difícil 11 - 20: difícil 21 - 34: moderadamente difícil 35 - 64: correcta para el estudiantado promedio 65 - 80: bastante fácil 81 - 89: fácil 90 - 94: muy fácil 95 -100: extremadamente fácil |

| Desviación estándar | Es una medida de la dispersión de las calificaciones respecto a la media; mide la magnitud de cuánto puede discriminar cada pregunta | -.- |

| Puntaje esperado aleatoriamente | Promedio de calificación que se esperaría que el estudiantado obtuviera si respondiera al azar | Debajo del 40 % |

| Ponderación deseada y efectiva | La ponderación deseada o peso de la pregunta respecto del total y la ponderación efectiva es una estimación de la ponderación o peso que realmente tiene la pregunta para contribuir a la dispersión total de las calificaciones | -.- |

| Índice de discriminación | Es la correlación entre las calificaciones ponderadas en la pregunta y las del resto de la prueba | Valores negativos: ítem invalido 0 - 19: discriminación muy débil 20 - 29: discriminación débil 30 - 50: discriminación adecuada 50 o más: discriminación muy buena |

| Eficiencia de discriminación | Qué tan bueno es el índice de discriminación en relación con la dificultad de la pregunta | Superior al 50 % |

Fuente: elaboración propia con base en Caro y Ahumada (2018a)

También se aplicaron herramientas cualitativas de análisis textual sobre la valoración que el estudiantado hizo de diversos aspectos relacionados a la evaluación a través de estos instrumentos.

El uso de herramientas estadísticas cuantitativas y cualitativas constituyen una triangulación metodológica, que se refiere al uso de dos o más métodos de investigación sobre un mismo objeto de estudio. Se trata de reunir y cruzar la información disponible y pertinente a un objeto de estudio (Cabrera, 2005), como es en este caso la validación de instrumentos de evaluación.

Resultados y discusión

En relación con el objetivo general (analizar la implementación de evaluaciones formativas mediante herramientas digitales en grupos masivos de la materia Estadística I), se realizaron comparaciones de los resultados obtenidos en el examen final de la materia entre quienes hicieron las evaluaciones formativas propuestas versus quienes no las realizaron (o tuvieron baja participación).

De las pruebas realizadas (test t) se obtuvieron diferencias significativas en las notas promedio al comparar el grupo que realizó tres o más autoevaluaciones (más participativo) versus el grupo que realizó dos o menos (menos participativo), por un lado y luego al comparar el grupo más participativo con el grupo que no realizó estas evaluaciones (no participativo). La Tabla 3 presenta estas pruebas donde los valores de probabilidad (p-value) y los intervalos de confianza confirman las diferencias significativas encontradas.

El grupo de estudiantes más participativos presenta una nota promedio en sus exámenes, mayor a la nota promedio de los restantes grupos.

Si bien pueden existir otras variables que afectan los buenos resultados que obtiene el estudiantado, estas autoevaluaciones constituyen una preparación para instancias superiores de evaluación.

Tabla 3 Diferencia de medias

| Variable | Grupo 1 | Grupo 2 | Diferencia de medias | LI (95%) | LS (95%) | p-value |

| Nota del examen | 3 o más autoevaluaciones | 2 o menos autoevaluaciones | 1,21 | 0,56 | 1,86 | 0,0003 |

| Nota del examen | 3 o más autoevaluaciones | Ninguna autoevaluación | 1,08 | 0,29 | 1,86 | 0,0076 |

Fuente: elaboración propia.

Dentro del primer objetivo específico (identificar las posibilidades de la herramienta cuestionarios de la plataforma Moodle para mejorar la calidad del instrumento de evaluación) se presentan, a continuación, los indicadores de los cuestionarios administrados.

Para el cuestionario administrado en 2016 (Tabla 4), los indicadores globales arrojaron algunas medidas inadecuadas:

- promedio de todos los intentos menor al 50 % (42,86%), lo que significa que las calificaciones en promedio, obtenidas por el estudiantado que finalizó el cuestionario, es baja,

- coeficiente de consistencia interna, menor al 70 % (56,10%), por lo que la fiabilidad de la prueba no es buena,

- ratio de error mayor al 50 % (66,26%), lo que significa la existencia de causas aleatorias que afectan a la prueba,

- error estándar para todos los intentos mayor al 8 % (12,96%), lo que indica la incertidumbre en la calificación.

De esta primera exploración se concluye que el cuestionario no es adecuado para cumplir con el objetivo propuesto y es necesario realizar cambios. ¿Qué cambios son los que se pueden hacer y que se traduzcan en una mejora en los instrumentos?

Para ello, se analizan las estadísticas de cada pregunta (Tabla 5) para el año 2016. Respecto al índice de dificultad, cuatro preguntas resultan ser muy fáciles (menor al 30%), siete no discriminan; es decir, presentan baja correlación entre las calificaciones ponderadas en la pregunta con las del resto del examen y, por último, la eficiencia discriminativa de seis preguntas resultó ser menor al 50 %. Con ello se concluye que el cuestionario no discrimina adecuadamente.

En una segunda etapa de esta investigación se modifican las preguntas que resultaron inadecuadas y que no permitieron lograr una buena evaluación, lo que dio lugar a un cuestionario modificado que fue aplicado en 2017. La Tabla 4 muestra mejores estadísticas globales, en el que se mantiene un poco elevado, respecto a los valores de referencia, el error estándar.

A través del análisis de los restantes indicadores se evidencia:

- promedio de todos los intentos mayor al 50 % (54%), lo que significa que las calificaciones en promedio, obtenidas por el estudiantado que finalizó el cuestionario, es adecuada,

- coeficiente de consistencia interna mayor al 70 % (92%), por lo que la fiabilidad de la prueba es muy buena,

- ratio de error menor al 50 % (29%), lo que significa que la existencia de causas aleatorias que afectan a la prueba es baja respecto a las diferencias auténticas en la habilidad entre el estudiantado,

- error estándar para todos los intentos mayor al 8 % (11%); aunque sigue siendo inadecuado, es menor que el obtenido en el primer cuestionario.

Por lo anterior, el cuestionario es confiable, tiene una baja tasa de error y el promedio de los intentos ha mejorado.

Respecto a las estadísticas de cada pregunta, solo una resultó ser muy fácil (menor al 30 %) (Tabla 6).

De esta manera, se logra el segundo objetivo específico, (validar los cuestionarios a los fines de generar confiabilidad en los resultados obtenidos por el estudiantado), ya que luego de la evaluación del cuestionario, a través del cálculo de los indicadores presentados, se proponen ajustes y cambios al instrumento de manera justificada.

Tabla 4 Información general sobre el cuestionario - Años 2016 y 2017.

| Cuestionario | Año 2016 | Año 2017 | Indicador de referencia |

| Número de primeros intentos | 63 | 29 | |

| Número total de intentos | 63 | 29 | |

| Promedio de todos los intentos | 42,86% | 54,00% | 50% - 75% |

| Calificación mediana | 45,45% | 70,00% | |

| Desviación estándar | 19,55% | 36,00% | |

| Asimetría | -0,24 | -0,56 | |

| Curtosis | -0,93 | -1,36 | |

| Coeficiente de consistencia interna | 56,10% | 92,00% | >70% |

| Ratio de error | 66,26% | 29,00% | < 50% |

| Error estándar | 12,96% | 11,00% | 5% - 8% |

Fuente: elaboración propia en base a Caro y Ahumada (2018a)

Tabla 5 Comportamiento individual de cada ítem. Año 2016

| Ítem/pregunta | Índice de dificultad (30% - 70%) | Índice de discriminación (más del 30 %) | Eficiencia discriminativa (más del 50 %) |

| 01 | 25,40 | 13,71 | 20,29 |

| 02 | 28,57 | 16,20 | 21,96 |

| 03 | 7,94 | 7,92 | 16,79 |

| 04 | 84,13 | 41,60 | 60,95 |

| 05 | 47,62 | 49,83 | 60,30 |

| 06 | 44,44 | 15,07 | 18,36 |

| 07 | 52,38 | 15,45 | 17,75 |

| 08 | 71,43 | 32,54 | 40,91 |

| 09 | 26,98 | 2,49 | 3,57 |

| 10 | 42,86 | 43,32 | 54,63 |

| 11 | 39,68 | 24,95 | 32,01 |

Fuente: elaboración propia en base a Caro et al. (2019)

Tabla 6 Comportamiento individual de cada ítem. Año 2017

| Ítem/pregunta | Índice de dificultad (30 % - 70 %) | Índice de discriminación (más del 30 %) | Eficiencia discriminativa (más del 50 %) |

| 01 | 65,63 | 63,83 | 67,86 |

| 02 | 53,13 | 57,34 | 69,24 |

| 03 | 59,38 | 77,49 | 88,61 |

| 04 | 62,5 | 82,82 | 91,06 |

| 05 | 40,63 | 51,96 | 69,84 |

| 06 | 46,88 | 58,81 | 74,83 |

| 07 | 66,67 | 91,75 | 96,99 |

| 08 | 15,63 | 35,01 | 73,70 |

| 09 | 59,38 | 81,98 | 93,16 |

| 10 | 65,63 | 88,91 | 95,52 |

Fuente: elaboración propia en base a Caro et al. (2019)

En forma comparativa, en la Tabla 4 y la Tabla 5 se presentan los resultados globales de ambos cuestionarios y los resultados de cada pregunta; se resaltan los valores no adecuados en cada una. Caro et al. (2019) indican que ''Luego, analizando la valoración de comportamiento del ítem, es posible identificar una posible acción a realizar en cada pregunta con el objetivo de mejorar la calidad del cuestionario” (p. 189).

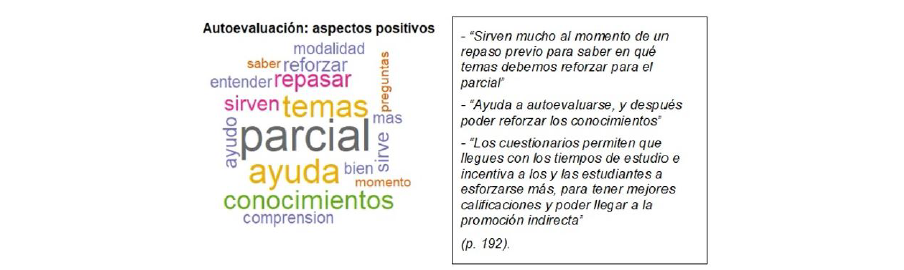

Por último, en relación al tercer objetivo planteado, al finalizar el curso se realizó una valoración de los cuestionarios por parte del estudiantado con aspectos positivos y negativos de los cuestionarios a través de una encuesta, cuyos resultados fueron presentados en Caro et al. (2019) y se transcribieron algunos comentarios relevantes (Figura 1 y Figura 2).

Del análisis textual realizado se observan que como aspectos positivos surgen principalmente las siguientes palabras:

Parcial: debido a que es considerado como herramienta de preparación para las evaluaciones parciales que son las que permiten que el estudiantado regularice la materia y lo consideran de ayuda para esa instancia.

Ayuda: el rol que cumplen estas evaluaciones previas al parcial.

Temas: fueron valorados positivamente los temas que se evaluaron.

Conocimientos: les permitió aprender o bien afianzar los conocimientos recibidos en las clases previas.

Fuente: elaboración propia en base a Caro et al. (2019)

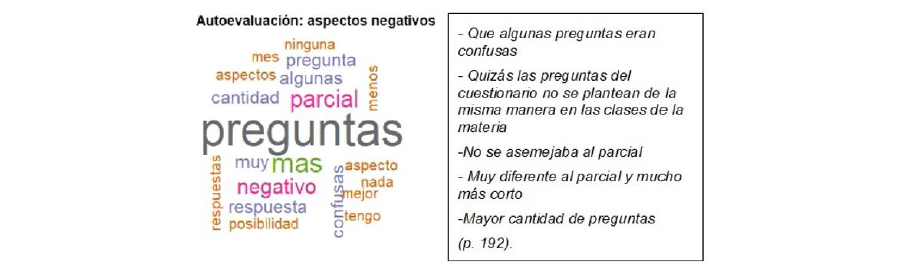

Figura 2 Palabras representativas de aspectos negativos y principales frases.

Como aspectos negativos surgen principalmente las siguientes palabras:

Preguntas: el estudiantado esperaba preguntas similares a las que se hacen en las clases, por lo que ante preguntas más complejas, que requieren determinados niveles de razonamiento, se vio amenazado y por ello las consideraron confusas o difíciles.

Parcial: destacaron que había diferencias con lo evaluado en el parcial, lo que está relacionado con la palabra anterior debido a que no hubo cuestionamientos idénticos en cuanto a forma, aunque sí se evaluaron los mismos contenidos.

Conclusiones

Es de destacar la importancia de la evaluación en entornos virtuales con instrumentos idóneos. Si a la evaluación en estos entornos se le agrega la masividad de los cursos que se tienen en la FCE- UNC, se torna imprescindible la realización de un adecuado análisis de datos de los resultados de los cuestionarios que actúan como mediadores pedagógicos en los procesos de enseñanza y de aprendizaje, dado el propósito formativo de la evaluación.

Evaluar virtualmente grupos masivos es un desafío y Moodle ofrece una serie de características que al ser estudiadas permiten un análisis completo de los instrumentos aplicados. Las funcionalidades de estos cuestionarios proveen de información que retroalimenta la evaluación hacia una mejora de la calidad.

El primer cuestionario aplicado al estudiantado del curso de Estadística mostró falencias importantes en su diseño, a partir de la interpretación del reporte de indicadores, por lo que no se permite identificar problemas de aprendizaje. El hecho de que los cuestionarios no evalúen lo que se pretende evaluar puede tener múltiples causas, entre ellas que el alumnado no entienda la pregunta o bien no haya aprehendido los conceptos que se están evaluado, entre otras causas.

En una segunda etapa, se realizaron los ajustes al cuestionario con la finalidad de mejorar las preguntas que atentan contra la confiabilidad del instrumento, para lograr una evaluación adecuada.

El uso del banco de preguntas permite combinaciones entre ellas, lo que permite generar distintos instrumentos de evaluación que son validados cuando los cuestionarios son instrumentados. De esta manera, las preguntas incorrectas o poco claras son reemplazadas por nuevas preguntas, o bien por preguntas modificadas y corregidas; con ello se logran cuestionarios fiables y válidos.

En definitiva, esta acción pone en relieve la importancia de diseñar e implementar este tipo de actividades para fomentar la mayor participación del estudiantado en su aprendizaje y permite justificar por qué esta instancia debe formar parte del proceso de enseñanza.

Cabe mencionar que muchos profesores y profesoras desconocen estas potencialidades y no realizan un análisis exhaustivo de sus instrumentos de evaluación, por lo que es necesario dar a conocer estos resultados y transmitir este tipo de análisis a los equipos docentes de las instituciones de educación superior, para que incorporen estrategias que permitan una evaluación de calidad (Conde, 2005 y Hamodi et al., 2015).