Evaluación Heurística y método SIRIUS

En relación a los métodos de evaluación, existen variados tipos y desde distintas perspectivas metodológicas, como los test de usuarios, grupos focales, simulación cognitiva, cuestionarios especializados o evaluaciones heurísticas (Bermello Crespo, 2005).

Heurística es una palabra griega que significa “encontrar”, por lo tanto, se define como un principio para encontrar problemas de usabilidad (Nielsen, 1992). La evaluación heurística es un método ampliamente usado, donde un grupo de personas evaluadoras inspecciona una interfaz con base en criterios o heurísticas definidas, verificando si los elementos presentes en la interfaz de la persona usuaria cumplen con ciertos principios de usabilidad vigentes (Fernández Casado, 2018). La evaluación heurística es un método económico y permite detectar un porcentaje relevante de problemas de usabilidad. Sin embargo, este tipo de evaluación puede perder nociones o elementos propios del contexto de evaluación si no se tienen las heurísticas adecuadas, las que debieran resultar altamente significativas desde el punto de vista de la evaluación del producto web (Jiménez, Rusu, Roncagliolo, Inostroza y Rusu, 2011).

Asimismo, se han generado ciertas adaptaciones o variaciones de las evaluaciones heurísticas clásicas, como el método SIRIUS (“Sistema de Evaluación de la Usabilidad Web Orientado al Usuario y Basado en la Determinación de Tareas Críticas”). Se define como un sistema de evaluación de usabilidad web basado en las evaluaciones heurísticas que puede ser aplicado a cualquier interfaz y en cualquier fase del ciclo de vida del desarrollo del producto. SIRIUS permite cuantificar la usabilidad de un sistema y establecer rankings con base en el criterio de usabilidad, realizando una clasificación donde el principal objetivo es adaptar los resultados de la evaluación al contexto del sistema y determinar, para cada tipo de sitio web, las tareas críticas y adecuar el perfil de la persona usuaria al contexto del servicio evaluado (Fernández Casado, 2018).

En cuanto a la evaluación de usabilidad de sitios web de bibliotecas universitarias, diversas investigaciones han aplicado distintos métodos como test de usuarios, “think aloud test” (Kous, Pušnik, Heričko y Polančič, 2020) o check list (lista de verificación) de medición de usabilidad (Halin, Elly y Handoko, 2019). En particular, al hablar sobre evaluación heurística, comúnmente son aplicados criterios generales en las inspecciones realizadas (Muñoz-Egido y Hernández-Pérez, 2016; Travieso Rodríguez, Alonso Arévalo y Vivanco Secilla, 2007). Sin embargo, Muñoz-Egido y Vianello Osti (2017) se refieren al método SIRIUS aplicado a sitios web de bibliotecas universitarias, señalando que permite cuantificar y graduar resultados según la relevancia que se le asigne a cada una de las heurísticas, junto con su capacidad de ponderación para evaluar las tareas críticas para diferentes sitios web.

De esta manera, las principales ventajas de SIRIUS como método de evaluación responden a la estandarización de los resultados debido a su pauta fija que define las heurísticas y las sub-heurísticas de evaluación para sistematizar la recolección de datos, junto con su versatilidad o adaptabilidad para evaluar distintos tipos de sitios web. Sin embargo, es relevante considerar que no es aconsejable tomar una técnica de medición de usabilidad como concluyente por sí misma, sino que se sugiere mezclar distintas técnicas para enriquecer los resultados e identificar holísticamente los problemas de usabilidad en un servicio digital.

Por su lado, considerando que en este momento en Chile no existe una directriz de diseño y evaluación de sitios web de bibliotecas universitarias, y desde 2003 que la Comisión Asesora de Bibliotecas y Documentación (CABID) del Consejo de Rectores de Universidades de Chile (CRUCH) no ha generado un estándar que considere adecuadamente el funcionamiento de los sitios web de bibliotecas, como sí ha sido propuesto en otros países (Corda y Viñas, 2015), la investigación acerca de métodos de evaluación y mejora de la usabilidad toma especial relevancia.

Métodos

Luego de la caracterización de la evaluación heurística, se define a SIRIUS como la principal metodología para efectuar la medición a fin de poder obtener resultados de evaluación de usabilidad y compararlos, desde un enfoque cuantitativo. De esta manera, SIRIUS entrega las heurísticas a evaluar, toma en cuenta el tipo de sitio web sobre el que se está trabajando, define las tareas que son críticas de resolver y finalmente proporciona una medida porcentual del sitio web.

Unidad de análisis y criterios de selección de expertos

Para esta investigación se evaluaron los sitios web de 17 de las 18 bibliotecas de las universidades públicas de Chile , ordenadas en la siguiente tabla según su posición a nivel nacional en el ranking Webometrics :

Tabla 1 Lista de Universidades públicas de Chile según ranking Webometrics

Fuente: Webometrics, 2020.

Por su parte, el número de personas expertas que realizan la evaluación se define por las recomendaciones de Nielsen y Mack (1994), quienes establecieron que el número ideal es de 3 a 5 evaluadores para obtener resultados satisfactorios, debido a que un número inferior reduce la detección de problemas de usabilidad y un número superior no se justifica en función del costo/beneficio, ya que no contribuye a la eficacia en la aplicación de la técnica. Si bien, algunos autores difieren en el número idóneo de personas en rol de evaluación, dado que algunos sugieren un rango de cinco a ocho criterio experto, la conclusión tiende a ser la misma: la incorporación de más de 10 evaluadores no produce mejores resultados (Phillips, 2018).

En relación al perfil de expertos, se define como principales criterios de inclusión una alta experiencia en trabajo con sitios web, catálogos en línea de bibliotecas y servicios de información digital (ver Tabla 2).

Tabla 2 Perfil de personas expertas

| N° | Experiencia |

| Experto 1 | Bibliotecaria, más de 10 años de experiencia en diseño de catálogos y bases de datos. Estudios de postgrado en programación y diseño web. |

| Experto 2 | Bibliotecario, con más de 15 años de experiencia en bibliotecas universitarias, bases de datos, bibliotecas digitales, ingreso y búsqueda en catálogos. |

| Experto 3 | Periodista y diseñador web, con experiencia en diseño de sitios de bibliotecas, diseño y programación de catálogos de bibliotecas. |

| Experto 4 | Bibliotecaria, 10 años de experiencia en bibliotecas digitales, archivos, ingreso y búsqueda en catálogos y bases de datos. |

| Experto 5 | Bibliotecario, con 15 años de experiencia en bibliotecas y archivos digitales, búsquedas especializadas y diseño de bases de datos. |

Fuente: Elaboración propia, 2019.

Técnica de recolección de información

Pauta fija de SIRIUS

La recolección de datos se hace a través de una pauta fija que pide calificar cada una de las heurísticas o criterios proporcionados por el sistema SIRIUS. En esta pauta se detallan 10 heurísticas con sus 83 sub-heurísticas respectivas (ver anexo), analizadas detalladamente por cada persona experta en los 17 sitios web de bibliotecas de las universidades públicas de Chile, con el objetivo de calificarlas con una nota o sigla en una planilla proporcionada por el mismo sistema.

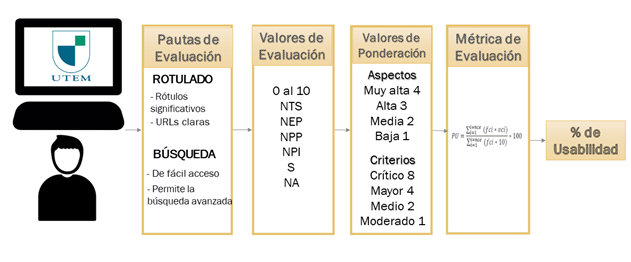

Además de la evaluación de cada criterio y su puntaje respectivo, la pauta entrega un sistema para obtener una métrica cuantitativa que va en el rango de 0 - 100 para medir el nivel de usabilidad en determinado sitio web, considerando la tipología del sitio web al momento de realizar ajustes en la medición. De esta manera, el sistema permite establecer una relación de criterios que no se han verificado de forma satisfactoria en el sitio web (Suárez, 2011).

Dado lo anterior, el sistema SIRIUS permite:

Comparar dos o más sitios web respecto al nivel de usabilidad alcanzado en los mismos.

Elaborar rankings de usabilidad en base a criterios uniformes.

Adicionalmente, en este método se pondera el valor del incumplimiento en una heurística de las webs evaluadas en función del tipo de sitio que sea, y a la vez entrega un valor de relevancia que nos indica cuán importante es corregir este problema dentro del sitio web. Para esto, el método SIRIUS divide los sitios en 16 categorías donde pondera las heurísticas según su objetivo (ver Tabla 3).

Tabla 3 Categorías de sitios

| Tipos de sitio web según SIRIUS | ||

| Administración pública institucional | Comercio electrónico | Descargas |

| Banca electrónica | Comunicación / Noticias | Educativo / Formativo |

| Blog | Corporativo / Empresas | Portal de servicios |

| Entornos colaborativos /Wikis | Foros / Chats | Ocio / Entretenimiento |

| Personal | Servicios interactivos Basados en imágenes | Servicios interactivos No basados en imágenes |

| Web mail / Correo | ||

Fuente: Suárez, 2011.

Para este estudio se consideró la categoría “Educativo/Formativo” que se define como “un sitio web cuya finalidad es proporcionar conocimiento al usuario” (Suárez, 2011). La decisión se fundamenta en que una biblioteca universitaria es parte del sitio web de la universidad, diseñada para ser utilizada en un entorno académico formado por estudiantes, docentes, investigadores y personal perteneciente a la institución.

Para la aplicación de SIRIUS, se entrega una pauta fija a los evaluadores con 83 criterios a evaluar (sub-heurísticas), los que se agrupan en aspectos más generales (heurísticas), que se definen a continuación:

Aspectos generales: elementos relacionados con los objetivos del sitio, el aspecto, coherencia y nivel de actualización de contenidos.

Identidad e información: elementos relacionados con la identidad del sitio, la información proporcionada sobre el proveedor y la autoría de los contenidos.

Estructura y navegación: elementos relacionados con la idoneidad de la arquitectura de la información y la navegación del sitio.

Rotulado: Elementos relacionados con la significación, corrección y familiaridad del rotulado de los contenidos. Que la escritura de la titulación, los letreros y encabezados sea correcta y coherente.

Layout (o diseño) de la página: elementos relacionados con la distribución y el aspecto de los elementos de navegación e información en la interfaz

Entendibilidad y facilidad en la interacción: elementos relacionados con la adecuación y calidad de los contenidos textuales, iconos y controles de la interfaz.

Control y retroalimentación: elementos relacionados con la libertad de la persona usuaria en la navegación y la información proporcionada en el proceso de interacción con el sitio.

Elementos multimedia: elementos relacionados con el grado de adecuación de los contenidos multimedia al sitio web.

Búsqueda: elementos relacionados con el buscador implementado en el sitio web.

Ayuda: Elementos relacionados con la ayuda ofrecida a la personas usuaria durante la navegación por el sitio.

De esta manera, se establecen parámetros que indican el cumplimiento del criterio según quien evalúa. Asimismo, se evalúa el cumplimiento a través de un mecanismo numérico (del 0 al 10) o por medio de una sintaxis que se describe en la Tabla 4:

Tabla 4 valores de evaluación

| Valor de Evaluación | Definición |

|---|---|

| NTS | No se cumple en todo el sitio |

| NEP | No se cumple en los enlaces principales. |

| NPP | No se cumple en la página principal. |

| NPI | No se cumple en alguna página interior |

| S | Se cumple el criterio |

| NA | Criterio no aplicable en el sitio. |

Fuente: Elaboración propia, 2020

Además, el método plantea una forma de ponderar el incumplimiento de los criterios en la métrica de evaluación, y para esto se utilizan dos valores. El primero pondera los criterios indicando cuál es más importante según el tipo de sitio web (en este caso Educativo/Formativo) con cuatro valoraciones: crítico, mayor, medio o moderado. Por su lado, el segundo valor indica la relevancia del aspecto dentro del tipo del sitio web y cuál es la prioridad para solucionar este aspecto, a través de 4 categorías: muy alta, alta, media y baja. (ver Figura 1).

Finalmente, se hace necesario obtener un valor cuantitativo que refleje el nivel de usabilidad obtenido tras la evaluación heurística de un sitio web. Para lograr lo anterior, se propone una fórmula donde se considera el factor de corrección, que corresponde al valor de ajuste aplicado a cada uno de los criterios evaluados con el fin de obtener diferentes niveles de usabilidad dependiendo de su relevancia en función del tipo de sitio en evaluación. Los valores resultantes al aplicar este factor de corrección debieran llevar a obtener valores de usabilidad comprendidos siempre entre 0 y 100.

El sistema pretende ser adaptable para cada tipo de sitio web, dando importancia no solo a la valoración de cada heurística, como hacen otros sistemas, sino, también, a la ponderación del incumplimiento de los criterios y la relevancia que tiene la resolución de determinado problema de usabilidad para un contexto específico.

Resultados

De acuerdo con los resultados de la aplicación de SIRIUS, el promedio de la evaluación de los sitios realizada por las cinco personas expertas fue de 62,82%. Asimismo, el porcentaje promedio más alto lo obtuvo la Universidad de la Frontera con un 70,15% y el porcentaje promedio más bajo lo obtuvo la Universidad de O’Higgins con un 46,99%. De igual manera, 13 de las 17 bibliotecas universitarias, lo que representa el 76,47% de la muestra, obtuvieron porcentajes sobre el 60%, lo que se considera un nivel de usabilidad satisfactorio (ver Tabla 5).

Tabla 5 Ranking de usabilidad de sitios web de bibliotecas universitarias de Chile: promediando la evaluación de los 5 expertos.

| Ranking | Universidades | Porcentaje final |

|---|---|---|

| 1 | Universidad de la Frontera | 70,15 |

| 2 | Universidad de Talca | 69,25 |

| 3 | Universidad Tecnológica Metropolitana | 68,05 |

| 4 | Universidad de Chile | 67,77 |

| 5 | Universidad de Playa Ancha | 67,16 |

| 6 | Universidad de los Lagos | 66,54 |

| 7 | Universidad de Santiago | 64,62 |

| 8 | Universidad Metropolitana de Ciencias de la Educación | 64,48 |

| 9 | Universidad de Valparaíso | 63,92 |

| 10 | Universidad de Tarapacá | 63,66 |

| 11 | Universidad de Magallanes | 63,14 |

| 12 | Universidad de Atacama | 62,97 |

| 13 | Universidad de Antofagasta | 60,45 |

| 14 | Universidad de la Serena | 58,02 |

| 15 | Universidad Arturo Prat | 53,46 |

| 16 | Universidad del Bío-Bío | 52,12 |

| 17 | Universidad de O’Higgins | 46,99 |

Fuente: Elaboración propia, 2019.

Resulta relevante identificar en detalle los porcentajes de usabilidad entre los distintos expertos que han evaluado los sitios web de bibliotecas universitarias. Si bien los criterios de evaluación son distintos, existiendo una diferencia entre el experto 1, que ha evaluado con la peor media de usabilidad total (54,05%), y el experto 5, que ha calificado con el mejor promedio total (74,53%), los resultados según universidad resultan simétricos de acuerdo a la calificación de los expertos (ver Tabla 6). Por esta razón, es necesario que la evaluación sea realizada por más de un experto para promediar los resultados y observar la tendencia en sus evaluaciones.

Tabla 6 Porcentaje de usabilidad de sitios web de bibliotecas universitarias con detalle por experto, ordenados de mayor a menor.

| Universidades | Experto 1 | Experto 2 | Experto 3 | Experto 4 | Experto 5 |

|---|---|---|---|---|---|

| Universidad de la Frontera | 64,22 | 69,34 | 62,75 | 71,52 | 82,94 |

| Universidad de Talca | 59,34 | 72,75 | 63,27 | 76,07 | 74,83 |

| Universidad Tecnológica Metropolitana | 61,47 | 67,68 | 67,73 | 70,95 | 72,44 |

| Universidad de Chile | 58,29 | 68,44 | 66,54 | 63,89 | 81,71 |

| Universidad de Playa Ancha | 56,11 | 63,36 | 71,56 | 63,89 | 80,9 |

| Universidad de los Lagos | 57,73 | 69,24 | 67,54 | 69,19 | 69 |

| Universidad de Santiago | 67,3 | 67,2 | 53,84 | 57,91 | 76,85 |

| Universidad Metropolitana de Ciencias de la Educación | 49,27 | 65,5 | 59,67 | 68,63 | 79,34 |

| Universidad de Valparaíso | 51,52 | 68,63 | 51,52 | 63,84 | 84,08 |

| Universidad de Tarapacá | 54,03 | 65,17 | 58,48 | 68,06 | 72,54 |

| Universidad de Magallanes | 54,69 | 66,73 | 55,88 | 66,35 | 72,04 |

| Universidad de Atacama | 54,08 | 65,7 | 61,47 | 70,43 | 63,15 |

| Universidad de Antofagasta | 53,89 | 52,65 | 64,74 | 55,43 | 75,55 |

| Universidad de la Serena | 49,34 | 50,05 | 44,27 | 67,42 | 79 |

| Universidad Arturo Prat | 52,56 | 45,83 | 35,36 | 61,61 | 71,94 |

| Universidad del Bío-Bío | 43,65 | 48,82 | 37,68 | 64,08 | 66,37 |

| Universidad de O’Higgins | 39,24 | 31,75 | 36,07 | 63,6 | 64,31 |

Fuente: Elaboración propia, 2019.

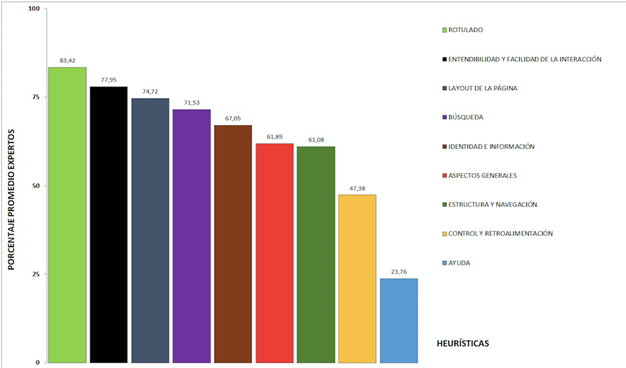

El análisis de las heurísticas resulta relevante para detectar las principales mejoras de usabilidad que pueden tener los sitios web de bibliotecas universitarias. Si vemos en detalle el porcentaje promedio de evaluación según heurística, podemos identificar que el “rotulado” es el aspecto mejor evaluado con un porcentaje promedio del 83,42%, seguido por la “entendibilidad y facilidad de la interacción” con un porcentaje promedio del 77,95%. A su vez, los aspectos peor evaluados fueron el “control y retroalimentación” con un 47,38% y la heurística “ayuda”, que presenta un brusco descenso en la evaluación con un 23,76% de promedio. Cabe señalar que ambos criterios son los únicos que están por debajo del 60% en todos los promedios de evaluación (ver Figura 2).

Fuente: Elaboración propia, 2019

Figura 2. Promedios por heurística, considerando los resultados de las evaluaciones de las cinco personas expertas.

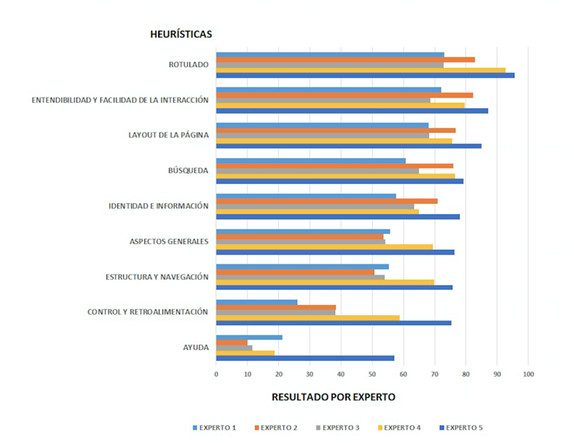

Al visualizar los resultados del porcentaje de cada heurística según el criterio de cada persona experta (ver Figura 3), se puede identificar que existe una relación simétrica en las evaluaciones de cada heurística. De igual modo, destaca el promedio de evaluación del aspecto “rotulado”, ya que cuatro de las cinco personas expertas evaluaron esta heurística como la mejor de todas, salvo la experto tres que evaluó como mejor aspecto el “layout o diseño de página”. Asimismo, a modo genérico las dos mejores heurísticas que le siguen a “rotulado”, “layout de la página” y “entendibilidad y facilidad de la interacción”.

Asimismo, todas las personas evaluadoras coinciden en que la heurística “ayuda” es la peor evaluada para los sitios web de bibliotecas universitarias, lo que indica que los distintos sitios web no ofrecen demasiada ayuda en el proceso de navegación.

Fuente: Elaboración propia, 2019

Figura 3 Gráfico de promedios por cada heurística evaluada, identificando los promedios obtenidos por las evaluaciones de las cinco personas expertas

Cabe señalar que la heurística “elementos multimedia” presente en el método SIRIUS se evaluó como NA (no aplica), ya que no todas las páginas contaban con imágenes, videos o sonidos a evaluar. Por lo tanto, este aspecto no se consideró, debido a que quienes evaluaron no lo encontraron aplicable al tipo de sitio que se estaba evaluando.

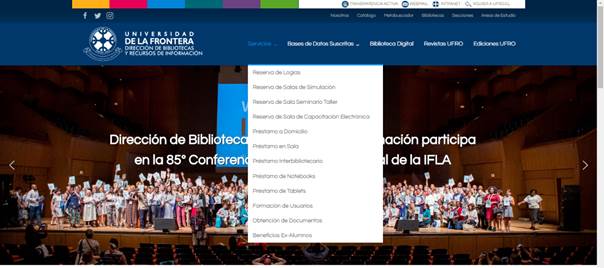

Por su parte, de acuerdo al análisis y a la identificación de la media de porcentajes más alta (ver Tabla 5), los sitios web de bibliotecas de la Universidad de la Frontera (ver Figura 4), la Universidad de Talca, la Universidad Tecnológica Metropolitana y la Universidad de Chile tienen los mejores indicadores de usabilidad.

Fuente: http://www.bibliotecas.ufro.cl/

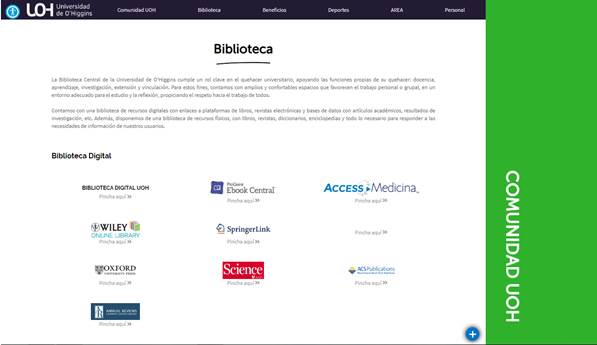

Al referirnos a los sitios con la calificación más baja, situados en un rango inferior al 60%, podemos encontrar a la Universidad de O’Higgins (46,99%), la Universidad del Bío-Bío (52,12%), la Universidad Arturo Prat (53,46%) y la Universidad de la Serena (58,02%). En estos casos, es preciso considerar elementos como el poco tiempo en funcionamiento y desarrollo que lleva la biblioteca de la Universidad de O’Higgins (ver figura 5).

Fuente: https://www.uoh.cl/#biblioteca

Discusión

A raíz del análisis previamente expuesto, es posible observar que en los sitios mejor evaluados se ofrece una gran cantidad de servicios como reservas de libros, revistas, reserva de computadores o salas, préstamos de materiales, bases de datos, bibliotecas digitales, ediciones de la universidad, entre otros, presentando el acceso a estos servicios de manera esquemática y bien rotulada.

Por su parte, aunque la Universidad de Chile y la Universidad de Talca están en los primeros lugares del ranking Webometrics a nivel nacional, no es posible establecer una relación directa entre la ubicación de la universidad en este ranking y el nivel de usabilidad del sitio web de su biblioteca según la evaluación arrojada por SIRIUS.

Asimismo, las bibliotecas universitarias situadas en la medianía del ranking, desde la Universidad de Santiago a la Universidad de Antofagasta, que obtuvieron entre un 65% y un 60% en la evaluación general, se distingue una particular asimetría entre los porcentajes que cada evaluador otorgó. Por ejemplo, en el caso de la Universidad de Valparaíso se observa una diferencia importante en las evaluaciones, ya que el experto 5 la evalúa con el porcentaje más alto otorgado por él (84,08%), mientras que la experta 1 y el 3 le otorgan un 51,52%. Lo mismo ocurre con la Universidad Metropolitana de Ciencias de la Educación, que fue evaluada por el experto 5 con un 79,34% y por la 4 con un 68,63%, mientras que el experto 1 le otorgó un porcentaje de 49,2%.

Por su parte, según la calificación de las personas que evaluaron, se demuestra que hay heurísticas que no fueron encontradas dentro del sitio y, por lo tanto, se evalúan como inexistentes, mientras que otros evaluadores sí las hallaron. En este caso, se identifica un problema de usabilidad, ya que no encontrar un aspecto dentro de la página es equivalente a que no exista, y para estos problemas se recomienda mejorar la estructura o reubicar contenidos para darle mayor visibilidad.

Al referirnos a las evaluaciones más bajas, el caso más atípico se muestra con la Universidad de La Serena, donde el experto 5 le entrega un 79% y la experta 4 un 67%, mientras la experta 1 y el 3 lo evalúan con un 49,34% y 44,27%. Esto muestra que no debemos guiarnos únicamente por el valor numérico, sino también es necesario analizar el detalle de las evaluaciones para justificar estas diferencias de criterio, compararlas en todas sus variables y tener un feedback con los expertos.

Si nos guiamos por las heurísticas mejor evaluadas y sus respectivas sub-heuríticas podemos señalar que el “rotulado”, es decir, la claridad y permanencia en etiquetas, títulos y URLs es la característica más destacada en los sitios web de bibliotecas universitarias de forma coincidente por los expertos.

Otras características destacadas son el “layout de la página”, ya que los sitios web presentan claridad en la interfaz, su espacio visual, claridad visual del texto y respetan ciertos principios del diseño (Fernández Casado, 2018), y la heurística de “entendibilidad y facilidad de interacción”, porque las personas expertas evalúan de forma positiva las distintas sub-heurísticas señalando que el lenguaje es claro, los párrafos se encuentran bien definidos, las metáforas son reconocibles, los menús son coherentes y están ordenados de manera lógica. Este aspecto es uno de los más relevantes, pues como dice su nombre tiene que ver con la interacción de la persona usuaria con el sitio web.

Por su parte, la heurística de “búsqueda” es considerada una de las más importantes para un sitio web de biblioteca, ya que el catálogo o el descubridor es el acceso a todos los recursos de la biblioteca, por lo tanto, se debe poner énfasis en su correcto funcionamiento y en la facilidad con la que lo pueda utilizar una persona usuaria (Ávila-García, Ortíz-Repiso y Rodríguez-Mateos, 2015). En este aspecto se evalúan sub-heurísticas que se refieren a la accesibilidad del buscador, su claridad, que posea un sistema fácil de usar, que permita la búsqueda avanzada, que muestre los resultados de forma clara y que ofrezca herramientas de ayuda a la persona usuaria (en caso de no poder obtener resultados). De este modo, las bibliotecas universitarias chilenas están evaluadas con un 71,53% en el ámbito de la búsqueda, lo que se reconoce como un resultado satisfactorio.

Finalmente, la heurística “ayuda” ha sido mal evaluada de forma consensuada. En términos concretos, este aspecto se refiere a los elementos relacionados con la ayuda ofrecida a la persona cuando este realiza la navegación durante el sitio (Súarez, 2011). Por lo tanto, quienes evalúan indican que las secciones de ayuda como “preguntas frecuentes” o formas de contacto no existen o son poco visibles, junto con no disponer de otros instrumentos de ayuda en el uso del sitio web.

Consideraciones finales

Sobre la evaluación heurística de expertos

La evaluación heurística por expertos es una de las mejores formas de encontrar problemas de usabilidad por sus bajos costos, la facilidad de su aplicación y la inmediatez de sus resultados. Una de las dificultades que presenta es encontrar personas expertas adecuadas para realizarla, que tengan la experiencia adecuada, la dedicación y cantidad de tiempo suficiente para indagar sobre cada heurística dentro de los sitios web.

Otra dificultad identificable es definir las heurísticas que se van a utilizar y, si estos criterios se encuentran previamente definidos, el problema radica en la forma de entender cada heurística para las personas expertas. Solamente de este modo se puede asegurar que todos las expertas evalúen con los mismos criterios.

Sobre SIRIUS

Resulta una herramienta útil para evaluar la usabilidad de un sitio web, de una forma estructurada, que permite comparar resultados finales de manera clara. Asimismo, resulta favorecedor que las heurísticas y sub-heurísticas se encuentren predefinidas como una forma de tener una pauta fija previamente desarrollada y probada sin necesidad de crearlas y perder tiempo en ese proceso.

Permite un trabajo transparente por parte de las personas expertas, porque al responder la pauta fija, en cada una de las sub-heurísticas, lo hacen sin influir en los resultados y el porcentaje final de usabilidad, por lo que resulta difícil que manipulen la evaluación final.

En contraparte, el sistema de pauta fija impide a las expertas ahondar en nuevos problemas de usabilidad identificados en el proceso o profundizar en el por qué existe un problema de usabilidad, sugiriendo cambios inmediatos para mejorarlos. Además, la pauta resulta muy extensa, considerando 83 criterios y distintos formatos de evaluación (siglas y números). Por este motivo, es indispensable una correcta capacitación de los evaluadores y una aplicación de la pauta en las condiciones adecuadas.

Sugerencias

Se sugiere complementar la evaluación del método SIRIUS con un estudio más abierto o flexible, que permita encontrar otros problemas de usabilidad que no estén reflejados en las heurísticas, o un sistema que permita hacer indicaciones específicas para generar mejoras en el sitio web, sobre todo si el estudio se hace desde dentro de la universidad o la biblioteca con el objetivo de generar mejoras en la interfaz. A modo complementario, también resulta conveniente compartir resultados entre las personas evaluadoras para establecer con mayor claridad los problemas de usabilidad que se repiten o son más críticos. En todo caso, este feedback de evaluadores debe realizarse una vez terminado el proceso de evaluación.

Para trabajos futuros, se propone desarrollar heurísticas propias del contexto de las bibliotecas y que le den mayor relevancia o ponderación al criterio de búsqueda, funcionamiento del catálogo o descubridor, servicios de reserva en línea, interoperabilidad de sus bases de datos, sistema de autenticación, entre otros criterios. Lo anterior supone un proceso de selección y validación de nuevas heurísticas, lo que constituye otro tipo de investigación.

Finalmente, el método SIRIUS resulta recomendable para la evaluación de usabilidad de sitios web de bibliotecas universitarias, porque es un método de evaluación validado, que permite obtener resultados con rapidez, de bajo costo y aplicable en distintas etapas del desarrollo del sitio web.