Los estándares actuales, para la evaluación de la calidad psicométrica de las pruebas psicológi cas y educativas, estipulan que una de las evidencias requeridas que justifican las inferencias deriva das de la aplicación de un test se refiere a las estrategias para contestar a los ítems que lo componen (American Educational Research Association, American Psychological Association & National Council on Measurement in Education, 2014; Padilla & Benítez, 2014). Este tipo de evidencias permite conocer detalladamente la forma en que los examinados resuelven los ítems de una prueba, lo cual es fundamen tal para establecer si esta se adecua al propósito para el que fue creada y a su marco teórico. En este sentido, esta estrategia de validación resulta necesaria para detectar posibles fuentes de varianza irrele vante al constructo que se pretende evaluar. También, posibilita averiguar si este está apropiadamente representado en los ítems (Haladyna & Downing, 2004; Messick, 1995).

Existen diferentes metodologías para recopilar información sobre las estrategias que utilizan las personas para abordar preguntas planteadas en instrumentos de papel y lápiz (Gorin, 2006). Desde técni cas de gran precisión, como el seguimiento ocular (Allen & Horsley, 2014) hasta aquellas mediante las cuales se pueden documentar algunos contenidos mentales, que se activan durante la ejecución de una tarea (Fox, Ericsson & Best, 2011; Smith & Molina, 2011). Muchos métodos de la psicología cognitiva han mostrado ser de gran utilidad para entender los procesos mentales involucrados en la resolución de pruebas estandarizadas (Embretson & Gorin, 2001); por ejemplo, los protocolos de pensamiento en voz alta (Ericsson & Simon, 1993) constituyen una herramienta crucial para validar matrices de atributos en los modelos de diagnóstico cognitivo (Rupp, Templin & Henson, 2010; Svetina, Gorin & Tatsuoka, 2011; Wang & Gierl, 2011). Así, son muy útiles para determinar si los examinados emplean las estra tegias que, según los desarrolladores de un test, son imprescindibles para resolver correctamente los ítems (Cohen & Upton, 2007; Rupp, Ferne & Choi, 2006; Schroeder, 2011). Esta técnica también suele utilizarse en las fases iniciales del desarrollo de un test (Anguas, 2001; Díaz, Cumba, Bernal & Rivera, 2008; Martínez & Nuñez, 2007; Remor, 2005). Para una aplicación de esta técnica, en Costa Rica, puede consultarse el trabajo de Villarreal (2011), en el cual se realiza una descripción exhaustiva de los proce sos de resolución de una prueba de razonamiento con figuras a partir de los reportes en voz alta de los estudiantes y del criterio de expertos sobre las estrategias y las reglas que utilizaron para contestar a las preguntas de dicha prueba.

La necesidad de identificar con cierto nivel de detalle las estrategias utilizadas por los examina dos para responder a los ítems de un test estandarizado es relativamente reciente en comparación con la larga trayectoria que posee este tipo de pruebas (Hunt, 2011). Esta línea de investigación se ha cons truido a partir de la indagación (mediante entrevistas semiestructuradas y autorreportes verbales) sobre las destrezas que utilizan las personas para resolver ítems en pruebas estandarizadas. A continuación, se exponen algunos ejemplos de la aplicación de esta técnica en el contexto de pruebas estandarizadas de comprensión lectora.

Por ejemplo, Farr, Pritchard & Smitten (1990) mediante entrevistas introspectivas y retrospectivas lograron determinar que, pese a las diferencias entre las estrategias empleadas para resolver una prueba estandarizada, los examinados se interesaban fundamentalmente por leer las preguntas primero, para luego enfocarse en el pasaje correspondiente.

Por su parte, mediante la técnica de entrevista, Powers y Wilson (1995) lograron descubrir que un grupo de examinados a quienes se les presentaron ítems de comprensión lectora del Scholastic Aptitude Tests sin los respectivos textos o pasajes obtuvieron notas altas en la escala de puntuación, inclusive arriba de lo esperable por mero azar, y observaron que la estrategia más utilizada era la de examinar la consistencia entre las preguntas y reconstruir el tema original de estas. A partir de lo anterior, los autores mencionan que estos ítems no muestran una relación directa con la comprensión de lectura, porque el texto principal resulta prescindible para contestarlos correctamente.

En otro estudio, Rupp, Ferne y Choi (2006) analizaron los datos extraídos de diez entrevistas cog nitivas con lectores no nativos del inglés, a los cuales se les proporcionaron tres pasajes con varias pre guntas de selección única provenientes del Canadian Test of English for Scholars and Trainees (Official Languages and Bilingualism Institute, 2015) y lograron identificar las siguientes estrategias para respon der a las preguntas: a) leer superficialmente el pasaje, luego las preguntas y buscar palabras claves en el texto principal para escoger la opción correcta; b) leer todo el pasaje, buscar palabras claves, leer todas las opciones, buscar términos claves en las opciones y responder a las preguntas; c) leer primero las preguntas, luego el texto principal y contestar y d) leer las preguntas y buscar palabras claves en el texto principal para ir respondiendo a las preguntas, según los términos que los lectores iban encontrando.

Con base en este breve recuento, se concluye que los autorreportes verbales en voz alta son su mamente útiles para aportar evidencias sobre el constructo medido por un test y las posibles fuentes de varianza irrelevante, que pudieran afectar la medición de este (Castillo & Padilla, 2013; Cui & Roduta, 2013; Ercikan et al., 2010; Taylor & Dionne, 2000) siempre y cuando se utilice correctamente (Cromley & Azevedo, 2006; Leighton, 2004; Leighton & Gierl, 2007a) y en un contexto relevante (Leighton & Gierl, 2007b).

El objetivo de la presente investigación fue aplicar este método para recopilar evidencias de va lidez sobre los procesos de respuesta, que utilizan los examinados al enfrentarse a la Prueba de Aptitud Académica (PAA) de la Universidad de Costa Rica. Este estudio se basa en la perspectiva contemporá nea sobre la validez en el ámbito de las pruebas psicológicas y educativas (Borsboom, Mellenbergh & Heerden, 2004; Cronbach & Meehl, 1955; Embretson, 1996; Embretson & Gorin, 2001; Gorin, 2007; Markus & Borsboom, 2013; Messick, 1995). De acuerdo con estos enfoques, la validez de las inferen cias derivadas de las puntuaciones en un test está garantizada cuando a) el constructo existe como tal y b) las variaciones en este causan las variaciones en los puntajes obtenidos en el test. Por tal motivo, un reto primordial para la toma de decisiones basada en la aplicación de pruebas estandarizadas consiste en el de contar con evidencias empíricas, que permitan vincular las respuestas a los ítems a un conjunto determinado de estrategias para resolverlos. La presente investigación brinda un aporte en esta línea de investigación sobre la comprensión de las estrategias de respuesta utilizadas para contestar a los ítems verbales de una prueba de selección a la Universidad de Costa Rica (UCR) y a la Universidad Nacional de Costa Rica (UNA).

En lo que respecta a la PAA, esta prueba se aplica anualmente a quienes desean ingresar tanto a la UCR como a la UNA. Se creó con el propósito de evaluar habilidades de razonamiento general en contextos verbales y matemáticos. A partir de varios estudios (Jiménez & Morales, 2009-2010; Molina, Gallardo & Cordero, 2011; Montero, Villalobos & Valverde, 2007; Rojas, 2013), ha sido posible recabar evidencias sobre la capacidad predictiva de este test, las cuales indican que la PAA permite predecir de manera efectiva el rendimiento académico de los estudiantes que ingresan a la UCR. Sin embargo, de acuerdo con las perspectivas psicométricas contemporáneas (Montero, 2013), el proceso de validación de las inferencias realizadas a partir de los puntajes de un test debe incorporar evidencias de diversa ín dole, no solo en cuanto a su validez predictiva.

Por ello, se han realizado diversas investigaciones sobre la calidad técnica de los ítems de la PAA al utilizar técnicas tales como (1) el Modelo Lineal de Rasgo Latente para identificar posibles predictores de la dificultad de los ítems (Brizuela & Montero, 2013), (2) el modelo de Rasch para evaluar la dificul tad de los ítems y su confiabilidad (Cerdas, 2011), (3) el Análisis Factorial Confirmatorio para determinar la estructura interna de la Prueba (Molina & Villalobos, 2010) y (4) las entrevistas semiestructuradas para evidenciar los procesos de resolución de las analogías en la parte verbal de la Prueba (Rodríguez, Fallas & Morales, 2009).

Así, el presente estudio se enmarca en esta línea de investigación para recopilar evidencias de va lidez de las inferencias, que se realizan con base en las puntuaciones derivadas del uso de la PAA. Para ello, se aplica la técnica de los autorreportes verbales en voz alta para la identificación de los procesos de razonamiento empleados en la resolución de los ítems verbales de la PAA.

Método

El diseño de la presente investigación es de tipo descriptivo y transversal, en el tanto en el que se describen las estrategias de resolución de los ítems reportadas en voz alta y los datos solamente se recogieron en una ocasión.

Participantes

El muestreo utilizado en la presente investigación fue de tipo no probabilístico y a conveniencia, porque interesó a seleccionar a estudiantes con las notas más altas en la Prueba de Aptitud Académica aplicada en el año 2014. En la investigación participaron 15 estudiantes (8 hombres y 7 mujeres) de la Universidad de Costa Rica, quienes estaban cursando el primer año en esta institución. Se utilizaron dos criterios para seleccionar a estos estudiantes: 1) haber contestado correctamente, al menos, el 90 % de las preguntas de la PAA y 2) provenir de una institución pública de educación secundaria. Todos los participantes fueron contactados por vía telefónica y antes de iniciar las entrevistas leyeron y firmaron un consentimiento informado de participación aprobado por el Comité de Ética de la UCR.

El primer criterio de selección se justifica porque para reportar en voz alta las estrategias utilizadas en la resolución de los ítems se requiere una gran habilidad verbal, puesto que el reporte se realiza de manera simultánea al proceso de respuesta. Este tipo de tareas demanda una gran cantidad de recursos cognitivos, por lo cual fue necesario garantizar que los participantes podían abordar de manera exitosa tanto la resolución de los ítems de la prueba como el reporte en voz alta de las estrategias empleadas. El segundo criterio de selección se basa en que los estudiantes provenientes de colegios públicos constituyen una gran mayoría de la población que ingresa a la UCR (Programa Estado de la Nación, 2013), por lo cual interesaba que el perfil de los participantes fuera similar al de quienes mayoritariamente realizan la PAA.

Instrumentos

Banco de ítems de la PAA: un total de 569 ítems verbales del banco de ítems de la PAA. En primer lugar, cabe señalar que los ítems utilizados en la parte de razonamiento en contexto verbal se utilizan regularmente para el proceso de admisión a la UCR y a la UNA, por lo cual son de naturaleza confi dencial y no pueden ser incluidos en este trabajo. Por una parte, los ítems de comprensión de lectura se componen de un párrafo (entre 1 y 13 renglones de extensión), una pregunta que debe contestarse princi palmente con base en la información planteada en este y cinco opciones de respuesta (cuatro distractores y una opción correcta). Por otra parte, los ejercicios de completar oraciones consisten en párrafos (entre 1 y 5 renglones) en los que se eliminan una o varias palabras, las cuales aparecen en las opciones de respuesta junto con otras que no se adecuan al texto. En los ítems de completar oraciones, se le solicita a los examinados que elijan la opción en la que aparecen las palabras que completan correctamente el sentido del párrafo, mientras que en los de comprensión de lectura deben seleccionar una respuesta que se derive del párrafo.

Test para la entrevista: una prueba conformada por un subconjunto de 17 ítems de banco de la PAA.

Guía de entrevista: una guía de entrevista para obtener información específica sobre las estrategias de resolución empleadas, la cual contenía preguntas como las siguientes: ¿Cómo llegó a esa respuesta?, ¿qué información utilizó para contestar el ítem?, ¿por qué marcó esa opción?, ¿hay alguna palabra o frase particularmente útil para contestar el ítem?, entre otras.

Procedimientos

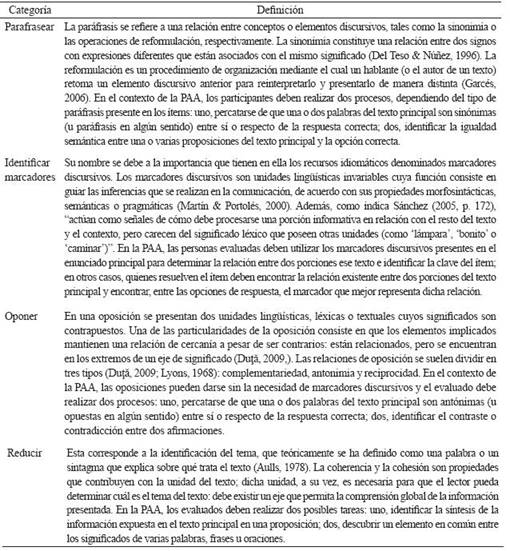

Los autores de la presente investigación resolvieron 569 ítems verbales del banco de ítems con que se cuenta para ensamblar los formularios de la PAA. De manera simultánea, se realizó una revisión bi bliográfica sobre teorías cognitivas, lingüísticas y pedagógicas y de cómo las personas entienden los tex tos escritos (Belinchón, Igoa & Rivière, 1998; Gutiérrez, 1999; Kintsch, 1998; McNamara & Magliano, 2009; Murphy, 2003). Con base en el criterio experto de los investigadores (quienes han trabajado en el desarrollo de la prueba durante varios años) y en los aportes teóricos señalados, se elaboró un sistema de categorías basado en los procesos de comprensión lectora documentados en la literatura y que, a su vez, respondiera a las estrategias específicas requeridas para resolver los ítems verbales de esta prueba (Parafrasear, Identificar marcadores, Oponer y Reducir), cuyas definiciones se incluyen en la Tabla 1.

Posteriormente, los 569 ítems fueron clasificados de acuerdo con las categorías definidas. Cabe señalar que las categorías con las que se clasificaron los ítems, se derivan directamente de los ítems del banco, por lo que fue imprescindible resolver la gran mayoría de los ítems del banco verbal con el obje tivo de abarcar la totalidad de las estrategias de resolución involucradas.

Posteriormente, de los 569 ítems del banco, se eligieron 17 ítems representativos de las siguien tes categorías de la Tabla 1: reducir, oponer, identificar marcador y parafrasear. Estas categorías fueron elegidas por ser de particular interés para los desarrolladores de la PRUEBA, quienes consideran que estas son inherentes a la comprensión lectora. A cada participante se le administraron los 17 ítems (en un orden diferente y al azar para cada uno) para que los resolviera en voz alta, esto es, para que reportara todo lo que pensaba mientras intentaba seleccionar una respuesta (reporte verbal concurrente); los ítems se administraron de uno en uno, en folios separados. Una vez elegida la opción, a los participantes se les realizaban las preguntas señaladas anteriormente para obtener más información sobre las estrategias empleadas (reporte verbal retrospectivo). Estas entrevistas fueron aplicadas entre el 11 de septiembre y el 4 de noviembre de 2013.

Finalmente, las entrevistas fueron codificadas de manera independiente, por dos de los autores, en términos de si para cada uno de los 17 ítems se evidenciaba que los estudiantes hubieran utilizado una estrategia relacionada con la categoría a la que fue inicialmente asignado cada ítem; es decir, la codifi cación (0 = no se utilizó la estrategia esperada y 1 = se utilizó la estrategia esperada) se realizó con el objetivo de corroborar que la clasificación hecha por los autores estuviera respaldada por la forma en que los estudiantes contestan a los ítems verbales de la PAA. Para evaluar la confiabilidad de los jueces, se utilizó el coeficiente kappa de Cohen para cada categoría.

Resultados

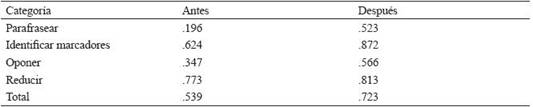

El coeficiente kappa de Cohen para cada categoría se expone en la Tabla 2. La columna “Antes” pre senta el kappa obtenido de una primera codificación independiente de los autores. Una vez observados estos valores, los jueces se reunieron para discutir las discrepancias en la codificación, que generaron valores bajos en el coeficiente kappa. Una vez realizada esta discusión, los autores volvieron a codificar las entre vistas de acuerdo con la misma consigna y se volvió a calcular el coeficiente kappa (columna “Después”).

Para la interpretación del coeficiente kappa de Cohen, se utilizaron los parámetros recomendados en la literatura (Landis & Koch, 1977). De acuerdo con Landis y Koch (1977), el coeficiente kappa se puede interpretar con los siguientes parámetros: pobre (menor a 0), ligero (0 - 0.20), justo (0.21 - 0.40), moderado (0.41 - 0.60), sustancial (0.61 - 0.80) y casi perfecto (0.81-1).

Como se puede observar en la Tabla 1, posteriormente a la reunión de los jueces, el coeficiente ka ppa para las categorías “parafrasear” y “oponer” es moderado, mientras que para las categorías “identi ficar marcador” y “reducir” resulta casi perfecto. De esta manera, las cuatro categorías expuestas se con sideran confirmadas mediante el acuerdo entre jueces, al menos, en un nivel moderado. A continuación, se muestran ejemplos de las frases registradas en las entrevistas que ratificanr el uso de las estrategias de resolución propuestas por los autores.

Parafrasear

Estas frases se encuentran en los reportes que dieron los participantes posteriormente a la resolu ción de cada ítem: “lo mismo” y “lo que dice arriba” se refieren al enunciado principal, o una porción de este, y son el medio utilizado por los participantes para justificar la escogencia de una opción determinada.

1. Es lo mismo, pero más resumido.

2. Es una traducción de lo que dice arriba.

3. La b sería lo mismo nada más que al revés.

4. Es lo que dice arriba con palabras distintas.

Identificar marcadores

En estos ejemplos, los participantes reportan el marcador discursivo específico que les permite reconocer la respuesta correcta para cada ítem: “es tan”, “como”, “si” y “aunque”. Además, el registro de los marcadores de los ejemplos 5), 6) y 7) está acompañado de una explicación de cómo ese elemento específico contribuye con la resolución del ítem: “está comparando”, “implica un símil” y “me remite a una condición”.

5. “Es tan”… está comparando.

6. Tenía dudas por el “como”, implica símil.

7. El elemento “si” me remite a una condición.

8. Hay una palabra importante; es el “aunque”.

Oponer

Como se puede apreciar en estos ejemplos, el reporte de los participantes suele implicar palabras directamente relacionadas con el nombre mismo de la categoría: “opuesto”, “contradicción”, “antagóni co”, como en 9), 10) y 11); sin embargo, hay explicaciones más amplias que exponen la relación existen te entre los elementos discursivos necesarios para resolver el ítem, tal como en la frase 12).

9. Tiene que ser algo opuesto.

10. Nos habla de una contradicción.

11. Estaba buscando algo antagónico.

12. Está dando un factor negativo, pero también causa algo bueno.

Reducir

En el reporte de la categoría “reducir”, en algunos casos, los participantes reconocen directamente qué se les pide, como en 13); otras veces utilizan frases que, precisamente, se relacionan con la definición teórica de tema, como en 14); en otros casos, confirman que deben utilizar un proceso definido para los ítems de esta categoría, como en 15) y 16).

13. Es el tema principal.

14. De qué me habla el texto.

15. Busco algo que pueda englobar todas estas condiciones.

16. Me piden la frase que relacione todas estas afirmaciones que vienen después, que son ejem plos del mismo concepto.

Discusión

La técnica de los autorreportes en voz alta demostró ser de gran utilidad para indagar sobre los pro cesos de respuesta a los ítems. Tal y como ha sido de gran utilidad para investigar otras pruebas, mediante esta técnica se evidenció que las estrategias planteadas por los autores las utilizan los examinados. A la luz de estos resultados, los autores recomiendan el uso de esta técnica como una primera aproximación para conocer la forma en que las personas se plantean la tarea de contestar los ítems de un test.

En esta investigación se presentó evidencia inicial sobre las estrategias utilizadas para contestar los ítems verbales de la PAA. En este sentido, se aportaron evidencias sobre los procesos de razonamiento que utilizan los examinados para contestar a este tipo de preguntas: identificar equivalencias u oposicio nes semánticas entre porciones de un enunciado o entre un enunciado y la opción de respuesta correcta; identificar la síntesis de la información expuesta en el texto principal en una proposición o descubrir un elemento en común entre los significados de varias palabras, frases u oraciones y utilizar los marcadores discursivos presentes en el enunciado principal para determinar la relación entre dos porciones ese texto e identificar la clave del ítem.

Los resultados también ofrecen una luz sobre las estrategias de razonamiento empleadas en tareas verbales, las cuales suelen denominarse tradicionalmente como “deducción”, “inducción” o “analogía”. En esta investigación se desglosaron detalladamente qué tipo de estrategias se emplean a la hora de abor dar los ítems verbales de la Prueba de Aptitud Académica, lo cual puede servir como guía para quienes se dedican a la construcción y el uso de pruebas estandarizadas relacionadas con habilidades verbales desean profundizar en el constructo medido por estas. En este sentido, los actuales estándares para la me dición psicológica y educativa (American Educational Research Association, American Psychological Association & National Council on Measurement in Education, 2014) plantean la necesidad de recabar evidencias de validez, las cuales son necesarias para fundamentar las inferencias, que se realizan con base en la aplicación de una prueba.

Para futuras investigaciones, este trabajo se podría complementar con el uso de técnicas analíticas cuantitativas, tales como el Análisis Factorial Confirmatorio, para recabar evidencias sobre si los ítems efectivamente se agrupan de acuerdo con las estrategias identificadas por los autores en esta prueba.